|

|

Основні наслідки мультиколінеарності.

Тема 3. Мультиколінеарність та її вплив на оцінки параметрів моделі

План

Поняття мультиколінеарності.

Ознаки мультиколінеарності.

Алгоритм Фаррара-Глобера.

Шляхи звільнення від мультиколінеарності.

В економетричних дослідженнях дуже важливо з'ясувати, чи існують між пояснювальними змінними взаємозв'язки, які називають мультиколінеарністю.

Мультиколінеарність означає існування тісної лінійної залежності, або сильної кореляці, між двома чи більше пояснювальними змінними.

Вона негативно впливає на кількісні характеристики економетричної моделі або робить її побудову взагалі неможливою.

Так, мультиколінеарність пояснювальних змінних призводить до зміщення оцінок параметрів моделі, через що з їх допомогою не можна зробити коректні висновки про результати взаємозв'язку залежної і пояснювальних змінних. У крайньому разі, коли між пояснювальними змінними існує функціональний зв'язок, оцінити вплив цих змінних на залежну взагалі неможливо. Тоді для оцінювання параметрів моделі метод найменших квадратів не придатний, оскільки матриця Х´X буде виродженою.

Нехай зв'язок між пояснювальними змінними не функціональний, проте статистично істотний. Тоді попри те, що оцінити параметри методом найменших квадратів теоретично можливо, знайдена оцінка може призвести до таких помилкових значень параметрів, що сама модель стане беззмістовною.

Основні наслідки мультиколінеарності.

1. Падає точність оцінювання, яка виявляється так:

а) помилки деяких конкретних оцінок стають занадто великими;

б) ці помилки досить корельовані одна з одною;

в) дисперсії оцінок параметрів різко збільшуються.

2. Оцінки параметрів деяких змінних моделі можуть бути незначущими через наявність їх взаємозв'язку з іншими змінними, а не тому, що вони не впливають на залежну змінну. У такому разі множина вибіркових даних не дає змоги цей вплив виявити.

3. Оцінки параметрів стають досить чутливими до обсягів сукупності спостережень. Збільшення сукупності спостережень іноді може спричинитися до істотних змін в оцінках параметрів.

З огляду на перелічені наслідки мультиколінеарності при побудові економетричної моделі потрібно мати інформацію про те, що між пояснювальними змінними не існує мультиколінеарністі.

Ознаки мультиколінеарності такі.

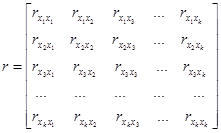

1. Коли серед парних коефіцієнтів кореляції пояснювальних змінних є такі, рівень яких наближається або дорівнює множинному коефіцієнту кореляції, то це означає можливість існування мультиколінеарності. Інформацію про парну залежність може дати симетрична матриця коефіцієнтів парної кореляції або кореляції нульового порядку між пояснювальними змінними:

Проте, коли до моделі входять більш як дві пояснювальні змінні, то вивчення питання про мультиколінеарність не може обмежуватись інформацією, що її дає ця матриця. Явище мультиколінеарності в жодному разі не зводиться лише до існування парної кореляції між незалежними змінними.

Більш загальна перевірка передбачає знаходження визначника (детермінанта) матриці r, який називається детермінантом кореляції і позначається |r|. Числові значення детермінанта кореляції задовольняють умову: |r|  [0,1].

[0,1].

2. Якщо |r| = 0, то існує повна мультиколінеарність, а коли |r| = 1, мультиколінеарність відсутня. Чим ближче |r| до нуля, тим певніше можна стверджувати, що між пояснювальними змінними існує мультиколінеарність. Незважаючи на те, що на числове значення |r| впливає дисперсія пояснювальних змінних, цей показник можна вважати точковою мірою рівня мультиколінеарності.

3. Якщо в економетричній моделі знайдено мале значення параметра âk при високому рівні частинного коефіцієнта детермінації  і при цьому F-критерій істотно відрізняється від нуля, то це також свідчить про наявність мультиколінеарності.

і при цьому F-критерій істотно відрізняється від нуля, то це також свідчить про наявність мультиколінеарності.

4. Коли коефіцієнт частинної детермінації  , який обчислено для регресійних залежностей між однією пояснювальною змінною та іншими, має значення, яке близьке до одиниці, то можна говорити про наявність мультиколінеарності.

, який обчислено для регресійних залежностей між однією пояснювальною змінною та іншими, має значення, яке близьке до одиниці, то можна говорити про наявність мультиколінеарності.

5. Нехай при побудові економетричної моделі на основі покрокової регресії введення нової пояснювальної змінної істотно змінюєінку параметрів моделі при незначному підвищенні (або зниженні) коефіцієнтів кореляції чи детермінації. Тоді ця змінна перебуває,очевидно,у лінійній залежності від інших, які було введено до моделі раніше.

Усі ці ознаки мультиколінеарності мають один спільний недолік: ні одна з них чітко не розмежовує випадки, коли мультиколінеарність істотна і коли нею можна знехтувати.

Найповніше дослідити мультиколінеарність можна за допомогою алгоритму Фаррара—Глобера. Цей алгоритм має три види статистичних критеріїв, згідно з якими перевіряється мультиколінеарність усього масиву незалежних змінних (χ2 — «хі»-квадрат); кожної незалежної змінної з рештою змінних (F-критерій); кожної пари незалежних змінних (t-критерій).

Усі ці критерії при порівнянні з їх критичними значеннями дають змогу робити конкретні висновки щодо наявності чи відсутності мультиколінеарності незалежних змінних.

Опишемо алгоритм Фаррара—Глобера.

Крок 1. Стандартизація (нормалізація) змінних.

Позначимо вектори незалежних змінних економетричної моделі через х1, х2, х3... хm . Елементи стандартизованих векторів обчислимо за формулами:

,

,

де n — число спостережень (і =  ); m — число пояснювальних змінних (k =

); m — число пояснювальних змінних (k =  );

);  — середнє арифметичне k-ї пояснювальної змінної;

— середнє арифметичне k-ї пояснювальної змінної;  — дисперсія k-ї пояснювальної змінної.

— дисперсія k-ї пояснювальної змінної.

Крок 2.Знаходження кореляційної матриці, виходячи з двох методів нормалізації змінних

,

,

де X* — матриця стандартизованих незалежних (пояснювальних) змінних;  — матриця, транспонована до матриці X*.

— матриця, транспонована до матриці X*.

Крок 3. Визначення критерію χ2 («хі»-квадрат):

,

,

де |r| — визначник кореляційної матриці r.

Значення цього критерію порівнюється з табличним при  ступенях вільності і рівні значущості α. Якщо χ2факт >χ2табл, то в масиві пояснювальних змінних існує мультиколінеарність.

ступенях вільності і рівні значущості α. Якщо χ2факт >χ2табл, то в масиві пояснювальних змінних існує мультиколінеарність.

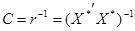

Крок 4. Визначення оберненої матриці:

.

.

Крок 5. Обчислення F-критеріїв:

,

,

де ckk — діагональні елементи матриці С. Фактичні значення критеріїв порівнюються з табличними при n-m і m-1 ступенях вільності і рівні значущості α. Якщо Fk факт > F табл., то відповідна k-та незалежна змінна мультиколінеарна з іншими.

Коефіцієнт детермінації для кожної змінної

.

.

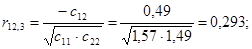

Крок 6. Знаходження частинних коефіцієнтів кореляції:

,

,

де ckj — елемент матриці С, що міститься в k-му рядку і j-му стовпці; ckk і cjj — діагональні елементи матриці С.

Крок 7. Обчислення t - критеріїв:

.

.

Фактичні значення критеріїв tkj порівнюються з табличними при n-m ступенях вільності і рівні значущості α. Якщо tkj(ф)>tтабл., то між незалежними змінними xk і xj існує мультиколінеарність.

Розглянемо застосування алгоритму Фаррара—Глобера для розв'язування конкретної задачі.

Приклад. На середньомісячну заробітну плату впливає ряд чинників. Вирізнимо серед них продуктивність праці, фондомісткість та коефіцієнт плинності робочої сили. Щоб побудувати економетричну модель заробітної плати від згаданих чинників згідно з методом найменших квадратів, потрібно переконатися, що продуктивність праці, фондомісткість та коефіцієнт плинності робочої сили як незалежні змінні моделі — не мультиколінеарні. Вихідні дані наведені в табл. 1.

1. Вихідні дані

| Номер цеху | Продуктивність праці, людино-днів | Фондомісткість, млн. грн. | Коефіцієнт плинності робочої сили, % |

| 0,89 0,43 0,70 0,61 0,51 0,51 0,65 0,43 0,51 0,92 | 19,5 15,6 13,5 9,5 23,5 12,5 17,5 14,5 14,5 7,5 | ||

| Σ | 6,16 | 148,1 |

Дослідити наведені чинники на наявність мультиколінеарності.

Розв 'язания

Крок 1. Нормалізація змінних.

Позначимо вектори незалежних змінних — продуктивності праці, фондомісткості, коефіцієнтів плинності робочої сили — через x1, x2, x3. Елементи стандартизованих векторів обчислимо за формулою:

,

,

де n — кількість спостережень, n=10; m — число незалежних змінних, m=3;  — середнє арифметичне значення вектора xk;

— середнє арифметичне значення вектора xk;  — дисперсія змінної xk.

— дисперсія змінної xk.

Із формули бачимо, що спочатку потрібно обчислити середні арифметичні для кожної пояснювальної змінної:

;

;  ;

;

.

.

Усі розрахункові дані для стандартизації змінних x1, x2, x3 згідно з поданими співвідношеннями наведено в табл. 2.

2.Розрахунок нормалізованих змінних

| №п/п |

|

|

|

|

|

|

|

|

|

| 3,3 0,3 1,3 2,3 -3,7 5,3 0,3 -4,7 -8,7 4,3 | 0,274 -0,186 0,084 -0,006 -0,106 -0,106 0,034 -0,186 -0,106 0,304 | 4,69 0,79 -1,31 -5,31 8,69 -2,31 2,69 -0,31 -0,31 -7,31 | 10,89 0,09 1,69 5,29 13,69 28,09 0,09 22,09 75,69 18,49 | 0,075076 0,034596 0,007056 0,000036 0,011236 0,011236 0,001156 0,034596 0,011236 0,092416 | 11,56 2,56 0,16 19,36 92,16 1,96 12,96 0,36 0,36 40,96 | 0,2487 0,0226 0,0980 0,1733 -0,2788 0,3994 0,0226 -0,3541 -0,6556 0,3240 | 0,0091 -0,3531 0,2580 0,0543 -0,1720 -0,1720 0,1448 -0,3531 -0,1720 0,7559 | -0,2518 0,1185 -0,0296 -0,3258 0,7108 -0,1037 0,2666 0,0444 0,0444 -0,4739 | |

| Σ | 176,1 | 0,278640 | 182,4 |

Дисперсії кожної незалежної змінної мають такі значення:

;

;  ;

;

.

.

Тоді знаменник для стандартизації кожної незалежної змінної буде такий:

;

;

;

;

.

.

Матриця стандартизованих змінних подається у вигляді:

Крок 2. Знаходження кореляційної матриці:

,

,

де X* — матриця нормалізованих пояснювальних змінних;  — матриця, транспонована до матриці X*.

— матриця, транспонована до матриці X*.

Ця матриця симетрична і має розмір 3x3.

Для даної задачі

Кожний елемент цієї матриці характеризує тісноту зв'язку однієї незалежної змінної з іншою. Оскільки діагональні елементи характеризують тісноту зв'язку кожної незалежної з цією самою змінною, то вони дорівнюють одиниці. Зауважимо, що при знаходженні добутку матриць  і X* за рахунок зміщеності коефіцієнтів парної кореляції числові значення діагональних елементів можуть наближатись до одиниці. Якщо це так, то вони заміняються одиницями, а інші значення матриці r збільшуються на величину, що визначається як різниця між одиницею і діагональним елементом.

і X* за рахунок зміщеності коефіцієнтів парної кореляції числові значення діагональних елементів можуть наближатись до одиниці. Якщо це так, то вони заміняються одиницями, а інші значення матриці r збільшуються на величину, що визначається як різниця між одиницею і діагональним елементом.

Інші елементи матриці r дорівнюють:

;

;

;

;

,

,

тобто вони є парними коефіцієнтами кореляції між пояснювальними змінними. Користуючись цими коефіцієнтами, можна зробити висновок, що між змінними x1, x2, x3 існує зв'язок. Але чи можна стверджувати, що цей зв'язок є виявленням мультиколінеарності, а через це негативно впливатиме на оцінку економетричної моделі?

Щоб відповісти на це запитання, потрібно ще раз звернутися до алгоритму Фаррара—Глобера і знайти статистичні критерії оцінки мультиколінеарності.

Крок 3. Обчислимо детермінант кореляційної матриці r і критерій χ2:

а)  ;

;

б)  .

.

При ступені вільності  =3 і рівні значущості α=0,01 критерій χ2табл.=11,34. Оскільки χ2факт <χ2табл., робимо висновок, що в масиві пояснювальних змінних не існує мультиколінеарності.

=3 і рівні значущості α=0,01 критерій χ2табл.=11,34. Оскільки χ2факт <χ2табл., робимо висновок, що в масиві пояснювальних змінних не існує мультиколінеарності.

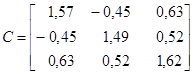

Крок 4. Знайдемо матрицю, обернену до матриці r:

;

;

.

.

Крок 5. Використовуючи діагональні елементи матриці С, обчислимо F-критерії:

;

;

;

;

.

.

Для рівня значущості α = 0,05 і ступенів вільності γ1 = 7 і γ2 = 2 критичне (табличне) значення критерію F = 4,74.

Оскільки

F1факт<Fтабл;

F2факт<Fтабл;

F3факт<Fтабл,

то кожна з пояснювальних змінних немультиколінеарна з двома іншими.

Щоб визначити наявність попарної мультиколінеарності, продовжимо дослідження і перейдемо до кроку 6.

Крок 6. Обчислимо частинні коефіцієнти кореляції, скориставшись елементами матриці С:

Частинні коефіцієнти кореляції характеризують тісноту зв'язку між двома змінними за умови, що третя не впливає на цей зв'язок.

Порівнявши частинні коефіцієнти кореляції з парними, які було наведено раніше, можна помітити, що частинні коефіцієнти значно менші за парні. Це ще раз показує, що на підставі парних коефіцієнтів кореляції не можна зробити висновків про наявність мультиколінеарності чи її відсутність.

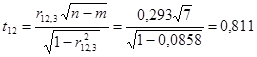

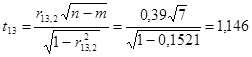

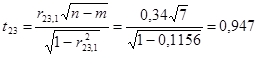

Крок 7. Визначимо t-критерій на основі частинних коефіцієнтів кореляції.

;

;

;

;

.

.

Табличне значення t-критерію при n-m = 7 ступенях вільності і рівні значущості α = 0,05 дорівнює 1,69. Усі числові значення t-критеріїв, знайдених для кожної пари змінних, менші за їх табличні значення. Звідси робимо висновок, що всі пари незалежних змінних не є мультиколінеарними.

Отже, усі пояснювальні змінні досліджуваної моделі не мультиколінеарні.

Якщо F-критерій більший за табличне значення, тобто коли k-та змінна залежить від усіх інших у масиві, то необхідно вирішувати питання про її вилучення з переліку змінних.

Якщо tkj — критерій більший за табличний, то ці дві змінні (k і j) тісно пов'язані одна з одною. Звідси, аналізуючи рівень обох видів критеріїв F і t, можна зробити обгрунтований висновок про те, яку зі змінних необхідно вилучити з дослідження або замінити іншою. Проте заміна масиву незалежних змінних завжди має узгоджуватись з економічною доцільністю, що випливає з мети дослідження.

Найпростіше позбутися мультиколінеарності в економетричній моделі можна, відкинувши одну зі змінних мультиколінеарної пари. Але на практиці вилучення якогось чинника часто суперечить логіці економічних зв'язків. Тоді можна перетворити певним чином пояснювальні змінні моделі:

а) узяти відхилення від середньої;

б) замість абсолютних значень узяти відносні;

в) стандартизувати пояснювальні змінні тощо.

За наявності мультиколінеарності змінних потрібно звертати увагу й на специфікацію моделі. Іноді заміна однієї функції іншою, якщо це не суперечить апріорній інформації, дає змогу уникнути явища мультиколінеарності.Коли жодний з розглянутих способів не дає змоги позбутися мультиколінеарності, то параметри моделі слід оцінювати за методом головних компонентів.