|

|

Техническое описание и технические характеристики

Введение

В данном курсовом проекте будут рассмотрены видеокарты.

Видеокарта, GPU (графический адаптер, graphics card, graphics adapter, display card, video card - eng.) - устройство компьютера, предназначенное для обработки и вывода видео сигнала на устройство отображения информации (монитор, ТВ). Имеет необходимые порты для вывода изображения. К примеру VGA, DVI, DisplayPort, HDMI.

Видеокарта является важным компонентом компьютера, и без нее невозможна полноценная работа современного ПК. На долю видеокарт приходится значительная доля неисправностей в ПК, поэтому необходимо точно и быстро определять и устранять поломки, связанные с видеокартой.

Курсовой проект состоит из трех разделов.

В первом разделе будет произведен обзор видеокарт, тоесть будет рассмотрено устройство и принцип действия видеокарт, приведена структурная схема устройства.

Во втором разделе курсового проекта речь идет о техническом обслуживании видеокарт, рассмотрены виды, методы технического обслуживания, приведена материально техническая база. Также разобраны типовые неисправности, способы их нахождения и устранения. В этом же разделе описаны способы утилизации неисправных элементов, оставшихся после ремонта СВТ, и описаны требования по комплектиции видеокарт, перечислены правила хранения, правила транспортировки.

В третьем разделе речь идет о технике безопасности и мерах пожарной безопасности при проведении ремота, и обслуживания СВТ.

Цели курсового проекта:

· Систематизация, закрепление и расширение теоретических знаний и практических навыков студента;

· Развитие навыков самостоятельного решения технических задач по организации и выполнению ремонта СВТ и КС;

· Формирование умений использовать справочную, нормативную и правовую документацию;

· Развитие творческой инициативы, самостоятельности, ответственности и организованности;

Задачи курсового проекта:

· Провести обзор видеокарт;

· Рассмотреть техническое обслуживание и ремонт видеокарт;

· Рассмотреть технику безопасности при ТО и ремонте видеокарт;

Обзор Видеокарт

Техническое описание и технические характеристики

История

Первая видеокарта для компьютеров архитектуры IBM PC была представлена миру в 1981 году и получила название MDA (Monochrome Display Adapter). Она не поддерживала графический режим и работала только с текстовыми данными. Видеоадаптер выводил на дисплей до 25 строк, каждая из которых вмещала 80 символов. Тексту можно было назначить один из пяти атрибутов: обычный, подчеркнутый, яркий, мигающий или инверсный. Задавать шрифт было нельзя, цвет букв также не поддавался изменению — эти параметры зависели исключительно от модели монитора.

Следующим этапом в развитии графических плат стало появление IBM CGA (Color Graphics Adapter). Видеоадаптер поддерживал четыре палитры по четыре цвета. Кроме того, он умел работать в графическом режиме, то есть на монитор выводился не только текст, но и пиксельные картинки. При работе с графикой максимальное поддерживаемое разрешение составляло 320х200 точек, а для монохромной палитры это значение возрастало до 640х200 точек. В графическом режиме использовалось не более 4 цветов одновременно. Следом за CGA последовала его усовершенствованная версия — EGA (Enhanced Graphics Adapter). Этот адаптер поддерживал 64-цветную палитру и мог обеспечить одновременно 16 цветов при разрешении 640x350.

Видеокарты, совместимые с описанными выше стандартами, использовали для взаимодействия с монитором цифровой интерфейс. Последующие видеоадаптеры поддерживали более высокие разрешения и большее количество цветов. При этом из-за возросшего количества информации цифровая передача данных уступила место аналоговой.

На смену EGA пришел адаптер VGA (Video Graphics Array), обеспечивающий 16 цветов при разрешении 640х480 или 256 цветов в режиме 320х200. В1987 году настала эпоха SVGA. Термином SVGA обозначались все режимы, превышающие VGA. У производителей не было четкого стандарта, которому бы соответствовала их продукция. Путаница была устранена только через три года, когда организация VESA (Video Enhanced Standards Association) ввела документ, описывающий режимы SVGA. Он несколько раз дополнялся, а в конечной его версии, датированной 1995 годом, описаны основные режимы работы, вплоть до разрешения 1600х1200 пикселей и цветопередачи True Color (16,7 млн цветов).

Ранние графические карты служили одно цели — они преобразовывали информацию, получаемую от процессора, в доступный для монитора вид. Они не производили расчетов. Цвет пикселей центральный процессор, что достаточно сильно перегружало его. С появлением первых 3D-движков ситуация ухудшилась — игры стали отнимать огромное количество ресурсов. Разумеется, существовали серьезные видеоадаптеры, которые использовались в профессиональном ПО, например САПР, но они были непомерно дороги.

Все это привело к появлению графических ускорителей — видеокарт, способных обрабатывать некоторые графические функции на аппаратном уровне. К примеру, они могли самостоятельно рассчитывать цвета отображаемых пикселей при рисовании линий или курсора, при перетаскивании окон и заливке отдельных участков изображения. Такие видеокарты не только преобразовывали сигнал, но и занимались построением изображения.

На рубеже 1994-95 годов разработчики стали задумываться о том, как ускорить игровые 3D-движки. В результате появились 3D-ускорители. Эти устройства могли работать только вместе с видеоадаптером, уже установленным в ПК. При запуске трехмерных приложений 3D-ускорители обрабатывали объемные модели, преобразуя их в двумерный вид. Результаты отправлялись видеокарте, которая при необходимости дополняла кадр различными объектами (например, интерфейсом) и передавала его на монитор. Со временем видеоадаптеры и 3D-ускорители слились воедино, и вот тогда-то видеокарты обрели свой нынешний вид.

Типы видеокарт компьютера:

o Встроенная видеокарта (встроенная графика, integrated videocard) - видеопроцессор встроенный в чипсет (набор логики) материнской платы либо в центральный процессор. Является ограниченной в плане максимального тепловыделения, потому мощные видеочипы для встроенных видеокарт, как правило, не используются. Таким чипам хватает производительности для 2D и 3D игр. Также они справляются с кодированием и воспроизведением HD видео благодаря встроенным декодерам. К примеру, технология QuickSync от Intel, использует встроенное в процессор видео ядро для быстрейшего декодирования видео. По скорости, данное решение обгоняет даже многие видеокарты основанные на декодировании с помощью технологий параллельного вычисления CUDA и OpenCL. Встроенные видеокарты, в качестве буфера используют оперативную память (ОЗУ). Это отрицательно сказывается на производительности всей системы. Но на некоторых материнских платах, бывает распаяна более быстрая память (к примеру GDDR 3) для нужд встроенного видеоадаптера. Это примерно в 1.5 раза повышает скорость текстуризации, сглаживания и других характеристик. У AMD, данная технология называется HyperMemory. Выходы встроенных видеокарт распаяны непосредственно на материнской плате.

Благодаря низкому энергопотреблению, основное применение интегрированных видеоадаптеров - портативные устройства, и недорогие домашние, офисные системы. Самыми распространёнными встроенными видеокартами являются видеочипы Intel (GMA Series, HD Graphics). Во многих процессорах и материнских платах установлен принудительно, но цена по этому поводу повышается незначительно (в сумме максимум +15$).

o Дискретная видеокарта (внешняя, отдельная) - второй по распространённости тип. Дискретная видеокарта вставляется в специальный слот (PCI-express, AGP, PCI) на материнской плате компьютера или другого устройства. Имеет собственную систему питания и охлаждения. Отличается от встроенной значительно большими производительностью и тепловыделением. Зачастую, топовые видеокарты потребляют более 300W энергии при полной нагрузке

Основными производителями дискретных видеокарт являются компании Nvidia и AMD.

Дискретные видеокарты устанавливают на компьютеры средней или высокой мощности.

o APU (Accelerated Processing Unit) - система, содержащая процессор и аналог дискретной видеокарты в одном чипе. Видеокарта в APU обычно имеет достаточную производительность и универсальность для современных игр, декодирования видео и других вычислений. При этом обладает не высоким энергопотреблением и тепловыделением.

Самое главное, что может подтолкнуть на покупку APU - низкая цена такого решения. Такое возможно благодаря интеграции процессора, контроллера памяти, контроллера шины pci-express и видео ядра на одном кристалле, который стоит значительно дешевле чем два или три чипа. Отчасти APU является процессором со встроенным видео ядром, и для её нужд используется оперативная память.

Главным игроком на рынке APU является компания AMD (серии A4, A8 и другие). Хотя с другой стороны, процессоры от Intel тоже в какой то степени можно назвать APU, так как они заключены на одном кристалле с видео ядром.

Составные элементы видеокарт:

· Графический процессор

Графический процессор (Graphics Processing Unit (GPU) — графическое процессорное устройство) рассчитывает выводимое изображение, освобождая от этой обязанности центральный процессор, производит расчёты для обработки команд трёхмерной графики. Является основой графической платы, именно от него зависят быстродействие и возможности всего устройства. Современные графические процессоры по сложности мало чем уступают центральному процессору компьютера, и зачастую превосходят его. Архитектура GPU обычно предполагает наличие нескольких блоков обработки информации, а именно: блок обработки 2D-графики, блок обработки 3D-графики, в свою очередь, обычно разделяющийся на геометрическое ядро (плюс кэш вершин) и блок растеризации (плюс кэш текстур) и др.

· Видеоконтроллер

Видеоконтроллер отвечает за формирование изображения в видеопамяти, даёт команды RAMDAC на формирование сигналов развёртки для монитора и осуществляет обработку запросов центрального процессора. Кроме этого, обычно присутствуют контроллер внешней шины данных (например, PCI или AGP), контроллер внутренней шины данных и контроллер видеопамяти. Ширина внутренней шины и шины видеопамяти обычно больше, чем внешней (64, 128 или 256 разрядов против 16 или 32), во многие видеоконтроллеры встраивается ещё и RAMDAC. Современные графические адаптеры (ATI, nVidia) обычно имеют не менее двух видеоконтроллеров, работающих независимо друг от друга и управляющих одновременно одним или несколькими дисплеями каждый.

· Видео-ПЗУ

Видео-ПЗУ (Video ROM) — постоянное запоминающее устройство (ПЗУ), в которое записаны BIOS видеокарты, экранные шрифты, служебные таблицы и т. п. ПЗУ не используется видеоконтроллером напрямую — к нему обращается только центральный процессор.

BIOS обеспечивает инициализацию и работу видеокарты до загрузки основной операционной системы, задаёт все низкоуровневые параметры видеокарты, в том числе рабочие частоты и питающие напряжения графического процессора и видеопамяти, тайминги памяти. Также, VBIOS содержит системные данные, которые могут читаться и интерпретироваться видеодрайвером в процессе работы (в зависимости от применяемого метода разделения ответственности между драйвером и BIOS). На многих современных картах устанавливаются электрически перепрограммируемые ПЗУ (EEPROM, Flash ROM), допускающие перезапись видео-BIOS самим пользователем при помощи специальной программы.

· Видеопамять

Видеопамять выполняет роль кадрового буфера, в котором хранится изображение, генерируемое и постоянно изменяемое графическим процессором и выводимое на экран монитора (или нескольких мониторов). В видеопамяти хранятся также промежуточные невидимые на экране элементы изображения и другие данные. Видеопамять бывает нескольких типов, различающихся по скорости доступа и рабочей частоте. Современные видеокарты комплектуются памятью типа DDR, GDDR2, GDDR3, GDDR4 и GDDR5. Следует также иметь в виду, что помимо видеопамяти, находящейся на видеокарте, современные графические процессоры обычно используют в своей работе часть общей системной памяти компьютера, прямой доступ к которой организуется драйвером видеоадаптера через шину AGP или PCIE. В случае использования архитектуры Uniform Memory Access в качестве видеопамяти используется часть системной памяти компьютера.

Типы памяти:

FPM DRAM (Fast Page Mode Dynamic RAM — динамическое ОЗУ с быстрым страничным доступом) — основной тип видеопамяти, идентичный используемой в системных платах. Использует асинхронный доступ, при котором управляющие сигналы не привязаны жёстко к тактовой частоте системы

VRAM (Video RAM — видео ОЗУ) — так называемая двух портовая DRAM. Этот тип памяти обеспечивает доступ к данным со стороны сразу двух устройств, то есть есть возможно одновременно писать данные в какую-либо ячейку памяти, и одновременно с этим читать данные из какой-нибудь соседней ячейки.

WRAM (Window RAM) — вариант VRAM, с увеличенной на ~25 % пропускной способностью и поддержкой некоторых часто применяемых функций, таких как отрисовка шрифтов, перемещение блоков изображения и т. п. Применяется практически только на акселераторах фирмы Matrox и Number Nine, поскольку требует специальных методов доступа и обработки данных. Наличие всего одного производителя данного типа памяти (Samsung) сильно сократило возможности её использования.

EDO DRAM (Extended Data Out DRAM — динамическое ОЗУ с расширенным временем удержания данных на выходе) — тип памяти с элементами конвейеризации, позволяющий несколько ускорить обмен блоками данных с видеопамятью приблизительно на 25 %.

SDRAM (Synchronous Dynamic RAM — синхронное динамическое ОЗУ) пришёл на замену EDO DRAM и других асинхронных одно портовых типов памяти. После того, как произведено первое чтение из памяти или первая запись в память, последующие операции чтения или записи происходят с нулевыми задержками. Этим достигается максимально возможная скорость чтения и записи данных.

DDR SDRAM (Double Data Rate) — вариант SDRAM с передачей данных по двум срезам сигнала, получаем в результате удвоение скорости работы. Дальнейшее развитие пока происходит в виде очередного уплотнения числа пакетов в одном такте шины — DDR2 SDRAM (GDDR2), DDR3 SDRAM (GDDR3) и т. д.

SGRAM (Synchronous Graphics RAM — синхронное графическое ОЗУ) вариант DRAM с синхронным доступом. В принципе, работа SGRAM полностью аналогична SDRAM, но дополнительно поддерживаются ещё некоторые специфические функции, типа блоковой и масочной записи. В отличие от VRAM и WRAM, SGRAM является однопортовой, однако может открывать две страницы памяти как одну, эмулируя двухпортовость других типов видеопамяти.

MDRAM (Multibank DRAM — многобанковое ОЗУ) — вариант DRAM, разработанный фирмой MoSys, организованный в виде множества независимых банков объёмом по 32 КиБ каждый, работающих в конвейерном режиме.

RDRAM (RAMBus DRAM) — память, использующая специальный канал передачи данных (Rambus Channel), представляющий собой шину данных шириной в один байт. По этому каналу удаётся передавать информацию очень большими потоками, наивысшая скорость передачи данных для одного канала на сегодняшний момент составляет 1600 МБ/с (частота 800 МГц, данные передаются по обоим срезам импульса). На один такой канал можно подключить несколько чипов памяти. Контроллер этой памяти работает с одним каналом Rambus, на одной микросхеме логики можно разместить четыре таких контроллера, значит теоретически можно поддерживать до 4 таких каналов, обеспечивая максимальную пропускную способность в 6,4 ГБ/с. Минус этой памяти — нужно читать информацию большими блоками, иначе её производительность резко падает.

· Цифро-аналоговый преобразователь

Цифро-аналоговый преобразователь (ЦАП; RAMDAC — Random Access Memory Digital-to-Analog Converter) служит для преобразования изображения, формируемого видеоконтроллером, в уровни интенсивности цвета, подаваемые на аналоговый монитор. Возможный диапазон цветности изображения определяется только параметрами RAMDAC. Чаще всего RAMDAC имеет четыре основных блока: три цифроаналоговых преобразователя, по одному на каждый цветовой канал (RGB), и SRAM для хранения данных о гамма-коррекции. Большинство ЦАП имеют разрядность 8 бит на канал — получается по 256 уровней яркости на каждый основной цвет, что в сумме дает 16,7 млн цветов (а за счёт гамма-коррекции есть возможность отображать исходные 16,7 млн цветов в гораздо большее цветовое пространство). Некоторые RAMDAC имеют разрядность по каждому каналу 10 бит (1024 уровня яркости), что позволяет сразу отображать более 1 млрд цветов, но эта возможность практически не используется. Для поддержки второго монитора часто устанавливают второй ЦАП. Стоит отметить, что мониторы и видеопроекторы, подключаемые к цифровому DVI выходу видеокарты, для преобразования потока цифровых данных используют собственные цифроаналоговые преобразователи и от характеристик ЦАП видеокарты не зависят.

· Коннектор

Устройство, которое предназначено для соединения видеоадаптера с кабелем, идущим к монитору. Рассмотрим основные разъёмы, использующиеся для подключения устройств отображения информации.

¾ Аналоговый D-Sub разъём (также известен как VGA-выход или DB-15F)

Рис. 1. D-Sub разъём

Это давно известный всем и привычный 15-контактный разъём для подключения аналоговых мониторов. Сокращение VGA расшифровывается как video graphics array (массив пикселей) или video graphics adapter (видеоадаптер). Разъём предназначен для вывода аналогового сигнала, на качество которого может влиять множество разных факторов, таких, как качество RAMDAC и аналоговых цепей, поэтому качество получаемой картинки может отличаться на разных видеокартах. В современных видеокартах качеству аналогового выхода уделяется меньше внимания, и для получения чёткой картинки на высоких разрешениях лучше использовать цифровое подключение.

¾ Разъёмы DVI

Рис. 2. Разъёмы DVI

DVI — это стандартный интерфейс, чаще всего использующийся для вывода цифрового видеосигнала на ЖК-мониторы, за исключением самых дешевых. Существует три типа DVI-разъёмов: DVI-D (цифровой), DVI-A (аналоговый) и DVI-I (integrated — комбинированный или универсальный):

Этот разъем применяется в видео платах наиболее часто, он универсален и при помощи специальных переходников, идущих в комплекте поставки большинства видеокарт, к нему можно подключить также и обычный аналоговый ЭЛТ-монитор со входом DB-15F. Вот как выглядят эти переходники:

Рис. 3. Переходник DVI-to-D-Sub

Во всех современных видеокартах есть хотя бы один DVI-выход, а то и два универсальных разъёма DVI-I. D-Sub может отсутствовать (но его можно подключать при помощи переходников).

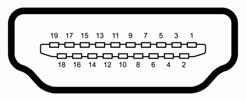

¾ Разъём HDMI

В последнее время широкое распространение получил новый бытовой интерфейс — High Definition Multimedia Interface. Этот стандарт обеспечивает одновременную передачу визуальной и звуковой информации по одному кабелю.

Рис. 4. Разъём HDMI

HDMI-выходы на видеокартах сейчас встречаются уже довольно часто, и таких моделей всё больше, особенно в случае видеокарт, предназначенных для создания медиа центров. Просмотр видеоданных высокого разрешения на компьютере требует видеокарты и монитора, поддерживающих систему защиты содержимого HDCP, и соединенных кабелем HDMI или DVI. Видеокарты не обязательно должны нести разъём HDMI на борту, например подключение HDMI-кабеля осуществляется и через переходник на DVI:

Рис. 5. Переходник DVI-to-HDMI

¾ Разъём DisplayPort

Первая версия цифрового видеоинтерфейса DisplayPort была принята VESA (Video Electronics Standards Association) весной 2006 года. Она определяет новый универсальный цифровой интерфейс, не подлежащий лицензированию и не облагаемый выплатами, предназначенный для соединения компьютеров и мониторов, а также другой мультимедийной техники. В группу VESA DisplayPort, продвигающую стандарт, входят крупные производители электроники: AMD, NVIDIA, Dell, HP, Intel, Lenovo, Molex, Philips, Samsung.

Основным соперником DisplayPort является разъём HDMI с поддержкой защиты от записи HDCP, хотя он предназначен скорее для соединения бытовых цифровых устройств, вроде плееров и HDTV-панелей.

Отсутствие лицензионных выплат важно для производителей, ведь за использование в своей продукции интерфейса HDMI они обязаны выплачивать лицензионные сборы организации HDMI Licensing, которая затем делит средства между держателями прав на стандарт: Panasonic, Philips, Hitachi, Silicon Image, Sony, Thomson и Toshiba.

Полноразмерный внешний разъём DisplayPort имеет 20 контактов, его физический размер можно сравнить со всем известными разъёмами USB..

Рис. 7. Разъём DisplayPort

¾ S-Video

Кроме вышеперечисленных разъёмов, на старых видеокартах также иногда встречаются композитный разъём и S-Video (S-VHS) с четырьмя или семью штырьками.

Рис. 8. Разъём и S-Video (S-VHS)

Чаще всего они используются для вывода сигнала на устаревшие аналоговые телевизионные приемники, и даже на S-Video композитный сигнал зачастую получают смешиванием, что негативно влияет на качество картинки. S-Video лучше по качеству, чем композитный «тюльпан», но оба они уступают компонентному выходу YPbPr.

· Система охлаждения

Система охлаждения предназначена для сохранения температурного режима видеопроцессора и (зачастую) видеопамяти в допустимых пределах.

Видеокарты могут потреблять (и, соответственно, выделять) столько же энергии, сколько 150-Вт лампочка. Подобное количество тепла, выделяемое с поверхности одного кремниевого чипа, может легко сжечь кристалл. Поэтому тепло следует своевременно отводить с помощью стабильных и мощных кулеров. Без систем охлаждения графический процессор или память могут перегреться, что приведёт к "повисанию" компьютера, а в худшем случае даже к выходу видеокарты из строя.

Охлаждение может осуществляться как пассивно с помощью теплопроводящих материалов и радиаторов, так и активно, если работает вентилятор.

· Интерфейс

Первое препятствие к повышению быстродействия видеосистемы — это интерфейс передачи данных, к которому подключён видеоадаптер. Как бы ни был быстр процессор видеоадаптера, большая часть его возможностей останется незадействованной, если не будут обеспечены соответствующие каналы обмена информацией между ним, центральным процессором, оперативной памятью компьютера и дополнительными видеоустройствами. Основным каналом передачи данных является, конечно, интерфейсная шина материнской платы, через которую обеспечивается обмен данными с центральным процессором и оперативной памятью. Самой первой шиной использовавшейся в IBM PC была XT-Bus, она имела разрядность 8 бит данных и 20 бит адреса и работала на частоте 4,77 МГц. Далее появилась шина ISA (Industry Standart Architecture — архитектура промышленного стандарта), соответственно она имела разрядность 16/24 бит и работала на частоте 8 МГц. Пиковая пропускная способность составляла чуть больше 5,5 МБ/с. Этого более чем хватало для отображения текстовой информации и игр с шестнадцати цветной графикой.

Дальнейшим рывком явилось появление шины MCA (Micro Channel Architecture) в новой серии компьютеров PS/2 фирмы IBM. Она уже имела разрядность 32/32 бит и пиковую пропускную способность 40 МБ/с.

С появлением процессоров серии 486, было предложено использовать для подключения периферийных устройств локальную шину самого процессора, в результате родилась VLB (VESA Local Bus — локальная шина стандарта VESA). Работая на внешней тактовой частоте процессора, которая составляла от 25 МГц до 50 МГц и имея разрядность 32 бит, шина VLB обеспечивала пиковую пропускную способность около 130 МБ/с. Этого уже было более чем достаточно для всех существовавших приложений, помимо этого возможность использования её не только для видеоадаптеров, наличие трёх слотов подключения и обеспечение обратной совместимости с ISA (VLB представляет собой просто ещё один 116 контактный разъём за слотом ISA) гарантировали ей достаточно долгую жизнь и поддержку многими производителями чипсетов для материнских плат и периферийных устройств, даже несмотря на то, что при частотах 40 МГц и 50 МГц обеспечить работу даже двух устройств подключенных к ней представлялось проблематичным из-за чрезмерно высокой нагрузки на каскады центрального процессора (ведь большинство управляющих цепей шло с VLB на процессор напрямую, безо всякой буферизации).

И всё-таки, с учётом того, что не только видеоадаптер стал требовать высокую скорость обмена информацией, и явной невозможности подключения к VLB всех устройств (и необходимостью наличия межплатформенного решения, не ограничивающегося только PC), была разработана шина PCI (Periferal Component Interconnect — объединение внешних компонентов) появившаяся, в первую очередь, на материнских платах для процессоров Pentium. С точки зрения производительности на платформе PC всё осталось по-прежнему — при тактовой частоте шины 33 МГц и разрядности 32/32 бит она обеспечивала пиковую пропускную способность 133 МиБ/с — столько же, сколько и VLB. Однако она была удобнее и, в конце концов, вытеснила шину VLB и на материнских платах для процессоров класса 486.

С появлением процессоров Pentium II стало ясно, что пропускной способности PCI в том виде, в каком она существовала на платформе PC (обычно частота 33 МГц и разрядность 32 бит) стало мало. Поэтому фирма Intel решила сделать отдельную шину для графической подсистемы, модернизировала шину PCI, обеспечила новой получившейся шине отдельный доступ к памяти с поддержкой некоторых специфических запросов видеоадаптеров и назвала это AGP (Accelerated Graphics Port — ускоренный графический порт). Разрядность шины AGP составляет 32 бит, рабочая частота 66 МГц. Первая версия разъёма поддерживала режимы передачи данных 1x и 2x, вторая — 4x, третья — 8x. В этих режимах за один такт передаются соответственно одно, два, четыре или восемь 32-разрядных слов. Версии AGP не всегда были совместимы между собой в связи с использованием различных напряжений питания в разных версиях. Для предотвращения повреждения оборудования использовался ключ в разъёме. Пиковая пропускная способность в режиме 1x — 266 МиБ/с. Но вскоре пропускной способности AGP стало мало. Также она не обеспечивала достаточного питания видеоадаптера.

Для решения этих проблем создано расширение шины PCI — PCI Express версий 1.0, 1.1 и 2.0. Это последовательный, в отличие от AGP, интерфейс, его пропускная способность может достигать нескольких десятков ГБ/с. На данный момент произошёл практически полный отказ от шины AGP в пользу PCI Express. Однако стоит отметить, что некоторые производители до сих пор предлагают достаточно современные по своей конструкции видео платы с интерфейсами PCI и AGP — во многих случаях это достаточно простой путь резко повысить производительность морально устаревшего ПК в некоторых графических задачах.

· Программные интерфейсы видеокарт

Графические платы стандартов MDA, CGA, EGA и VGA вообще не требовали драйверов — необходимое для работы устройств ПО было вшито в BIOS. Поскольку в рамках одного стандарта все видеокарты обладали одинаковой архитектурой и взаимодействовали с системой схожим образом, то разработчики приложений писали свои творения под определенный стандарт, а не видеокарту. Иначе говоря, все графические адаптеры со стороны программы выглядели одинаково.

Однако, когда настала эпоха SVGA, программисты столкнулись с рядом серьезных проблем. Например, не было четкого описания, как графическая плата должна работать в разрешении 640х480 при 256 цветах — разные видеокарты использовали этот режим по-своему. Разработчикам оставалось лишь адаптировать свои приложения для работы с каждой моделью видеокарты. Естественно, это было неудобно и отнюдь не способствовало прогрессу в сфере графических технологий. Появление стандартов VESA частично исправило ситуацию: режимы работы SVGA получили официальные спецификации, и все новые видеоадаптеры их учитывали.

Тот хаос, что создали первые SVGA-карты, подтолкнул программистов Microsoft к концепции общего интерфейса прикладного программирования — API. Впервые подобные интерфейсы для видеокарт были реализованы в Windows 95. Они стали промежуточным слоем между драйвером графической платы и самими приложениями. Другими словами, API — это программные стандарты, которые надлежит использовать разработчикам ПО, чтобы их приложения работали в определенной программной среде. При разработке игры код пишется под конкретный API, а производитель видеокарты гарантирует, что этот API совместим с драйвером графической платы.

Для создания приложений используется три интерфейса прикладного программирования:

· DirectX

Идея DirectX проста - предоставить разработчикам низкоуровневый доступ к аппаратному обеспечению (к видеокарте), в стиле MS-DOS, в независимом от конечного устройства виде, т.е. сохранив все преимущества "драйверного" подхода. В первую очередь DirectDraw и Direct3D (два графических интерфейса DirectX) были нацелены на достижение максимально высокой скорости работы с графикой и на обеспечение максимальной совместимости. При этом они также предоставляли массу дополнительных высокоуровневых функций облегчавших создание графики и анимации. Для обеспечения совместимости все базовые функции были продублированы программной эмуляцией, таким образом, даже если устройство не могло выполнять какую-либо функцию, она эмулировалась программно

Затем начали появляться DirectX совместимые карты. Такая карта на уровне своего драйвера поддерживала все или часть функций DirectX на аппаратном уровне, причем драйвер мог сообщать DirectX что он "умеет", а что - нет. Разработчики видеокарт сотрудничали с Microsoft предлагая включить в DirectX те или иные новые функции - таким образом DirectX потихоньку рос и расширялся.

Схема работы Direct3D, части DirectX интерфейса предназначенного для создания 3D графики, представлена на рис. 9.

Рис. 9. Схема работы Direct3D

Интерфейс DirectX появился вскоре после выхода Windows 95, и после этого все операционные системы начиная с Windows 95 OSR 2 несли у себя на борту ту или иную версию интерфейса DirectX. Также вместе с DirectX в Windows 95 OSR 2 появилась поддержка графического интерфейса OpenGL и это не случайно. Интерфейс DirectX принципиально состоит из двух независимых частей:

· низкоуровневой работающей с аппаратной частью;

· высокоуровневой работающей с программными вызовами.

Такая организация позволяет легко расширять вторую часть не меняя или минимально меняя первую, кроме того, первая часть может быть использования для присоединения к ней других интерфейсов. Например OpenGL в Windows функционирует именно так, то есть поверх DirectX.

· Интерфейс 3dfx Glide

Glide фирмы 3dfx первое время имел огромный успех. Популярность Glide была вызвана тем, что карты поддерживающие его на аппаратном уровне целиком, в отличие от DirectX и OpenGL, появились сразу же (правда это были только карты 3dfx). Популярность самих карт была вызвана тем, что они были первыми картами 3D-ускорителями поддерживающими не только собственный Glide, но и Direct3D с OpenGL (начиная с Voodoo2). Glide, будучи разработанным для вполне специфических карт показывал на них непревзойденную скорость. Однако по мере того как количество и популярность конкурентов росли, популярность Glide падала. 3dfx отчасти погубила собственная жадность - она не стала "открывать" Glide тем самым закрыв возможность встроить поддержку Glide в карты других производителей. Когда она решение открыть Glide было уже слишком поздно. Естественно, что производители игр не могли выпускать игру только с поддержкой Glide (хотя наличие такой поддержки долгое время было правилом хорошего тона), но как минимум с поддержкой Direct3D и/или OpenGL. Если же ресурсы команды были ограничены, то игра выпускалась обычно только под Direct3D или OpenGL. В числе недостатков Glide - отсутствие программной эмуляции, хотя это скорее было запланированным ходом 3dfx чем недоработкой.

Схема работы Glide приведена на рис. 10.

Рис. 10. Схема работы Glide.

o OpenGL интерфейс

OpenGL это промышленный стандарт интерфейса для 2D и 3D графики разработанный в начале 80-х годов фирмой Silicon Graphics. В отличие от Glide, OpenGL является открытым, так что любая фирма при желании может встроить его поддержку в свою операционную систему или видеокарту. В отличие от DirectX существующем только в Windows, OpenGL существует почти на всех системах, таким образом портирование OpenGL игры на различные платформы относительно простое. OpenGL как и DirectX предусматривает режим программной эмуляции. В общем то, когда OpenGL появлялся он и был чисто программным, его основной целью было создание удобного интерфейса для создания реалистичной 2D/3D графики, а идея о его аппаратном ускорении возникла уже позже.

Сегодня он не так востребован, как прежде. Как отмечают разработчики игр, вплоть до выхода DirectX 9 пользоваться OpenGL было удобнее, но в данный момент API от Microsoft предоставляет больше возможностей.

Для обеспечения максимальной совместимости приложений с графической подсистемой компьютера в них часто встраивают несколько путей кода — для разных API. Например, многие современные приложения поддерживают одновременно DirectX 9.0c и DirectX 10.

Рис. 11. Схема работы OpenGL.

· Драйвер

Дра́йвер— компьютерная программа, с помощью которой другие программы (обычно операционная система) получают доступ к аппаратному обеспечению некоторого устройства.

Типичный драйвер видеокарты состоит из четырех частей:

1. Драйвер, отвечающий за самый низкий уровень коммуникаций с видеокартой;

2. Драйвер для работы с интерфейсом Direct3D;

3. Драйвер для работы с интерфейсом OpenGL;

4. Специальное ПО, включающее в себя всевозможные средства настройки режимов работы видеокарты.

Характеристики видеокарт

1. Тактовая частота GPU

Эта характеристика прямо влияет на производительность видеочипа, чем она выше, тем больший объем работы чип может выполнить в единицу времени, обработать большее количество вершин и пикселей. В некоторых случаях тактовая частота отдельных блоков GPU отличается от частоты работы остального чипа.

2. Скорость заполнения (филлрейт)

Скорость заполнения показывает, с какой скоростью видеочип способен отрисовывать пиксели. Различают два типа филлрейта: пиксельный (pixel fill rate) и текстурный (texel rate). Пиксельная скорость заполнения показывает скорость отрисовки пикселей на экране и зависит от рабочей частоты и количества блоков ROP (блоков операций растеризации и блендинга), а текстурная — это скорость выборки текстурных данных, которая зависит от частоты работы и количества текстурных блоков.

Например, пиксельный филлрейт у GeForce GTX 275 равен 633 (частота чипа) * 28 (количество блоков ROP) = 17724 мегапикселей в секунду, а текстурный — 633 * 80 (кол-во блоков текстурирования) = 50640 мегатекселей/с. Чем больше первое число — тем быстрее видеокарта может отрисовывать готовые пиксели, а чем больше второе — тем быстрее производится выборка текстурных данных. Оба параметра важны для современных игр, но они должны быть сбалансированы. Именно поэтому количество блоков ROP в современных чипах обычно меньше количества текстурных блоков.

3. Количество блоков-шейдеров (пиксельные, вершинные). Вершинный шейдер отвечает за построение вершин объекта. Определяют возможности современных карт по обработке графических примитивных объектов, и в общем производительность самой карты. Пиксельный шейдер более актуальный чем вершинный поэтому количество их обычно больше. Разделение на пиксельные и вершинные в последнее время (с выходом Direct 10) теряют свою актуальность. Все они заменяются едиными унифицированными шейдерными блоками, которые зависят от конкретной ситуации. Они используют роль как пиксельных, так и вершинных шейдеров, а так же геометрических, которые появились в Direct 10.

4. Количество блоков текстурирования ТМU, которые определяют текстурную производительность или скорость выборки и наложения текстур. Особенно это актуально при анизотропной фильтрации. Наибольшее значение блоки ТМU имеют в старых приложениях. Сейчас они практически потеряли свою актуальность, т.к. пропускной способности шины памяти, в современных компьютерах не хватает для того, чтобы нормально функционировали высокопроизводительные карты. Большинство и них оснащены собственной памятью, которая требуется для хранения необходимых данных, а именно текстур, вершин и т.д.

5. Блоки операций растеризации (ROP)

Блоки растеризации осуществляют операции записи рассчитанных видеокартой пикселей в буферы и операции их смешивания (блендинга). Как мы уже отмечали выше, производительность блоков ROP влияет на филлрейт и это — одна из основных характеристик видеокарт всех времён. И хотя в последнее время её значение также несколько снизилось, всё ещё попадаются случаи, когда производительность приложений зависит от скорости и количества блоков ROP. Чаще всего это объясняется активным использованием фильтров постобработки и включенным антиалиасингом при высоких игровых настройках.

Ещё раз отметим, что современные видеочипы нельзя оценивать только числом разнообразных блоков и их частотой. Каждая серия GPU использует новую архитектуру, в которой исполнительные блоки сильно отличаются от старых, да и соотношение количества разных блоков может отличаться. Так, блоки ROP компании AMD в некоторых решениях могут выполнять за такт больше работы, чем блоки в решениях NVIDIA, и наоборот. То же самое касается и способностей текстурных блоков TMU — они разные в разных поколениях GPU разных производителей, и это нужно учитывать при сравнении.

6. Геометрические блоки

Вплоть до последнего времени, количество блоков обработки геометрии было не особенно важным. Одного блока на GPU хватало для большинства задач, так как геометрия в играх была довольно простой и основным упором производительности были математические вычисления. Важность параллельной обработки геометрии и количества соответствующих блоков резко выросли при появлении в DirectX 11 поддержки тесселяции геометрии. Компания NVIDIA первой распараллелила обработку геометрических данных, когда в её чипах семейства GF1xx появилось по несколько соответстующих блоков. Затем, похожее решение выпустила и AMD (только в топовых решениях линейки Radeon HD 6700 на базе чипов Cayman).

7. Объём видеопамяти

Собственная память используется видеочипами для хранения необходимых данных: текстур, вершин, данных буферов и т. п. Казалось бы, что чем её больше — тем всегда лучше. Но не всё так просто, оценка мощности видеокарты по объему видеопамяти — это наиболее распространенная ошибка! Значение объёма видеопамяти неопытные пользователи переоценивают чаще всего, до сих пор используя именно его для сравнения разных моделей видеокарт. Оно и понятно — этот параметр указывается в списках характеристик готовых систем одним из первых, да и на коробках видеокарт его пишут крупным шрифтом. Поэтому неискушённому покупателю кажется, что раз памяти в два раза больше, то и скорость у такого решения должна быть в два раза выше. Реальность же от этого мифа отличается тем, что память бывает разных типов и характеристик, а рост производительности растёт лишь до определенного объёма, а после его достижения попросту останавливается.

8. Ширина шины памяти.

Ширина шины памяти является важнейшей характеристикой, влияющей на пропускную способность памяти (ПСП). Большая ширина позволяет передавать большее количество информации из видеопамяти в GPU и обратно в единицу времени, что положительно влияет на производительность в большинстве случаев. Теоретически, по 256-битной шине можно передать в два раза больше данных за такт, чем по 128-битной. На практике разница в скорости рендеринга хоть и не достигает двух раз, но весьма близка к этому во многих случаях с упором в пропускную способность видеопамяти.

Современные игровые видеокарты используют разную ширину шины: от 64 до 384 бит (ранее были чипы и с 512-битной шиной), в зависимости от ценового диапазона и времени выпуска конкретной модели GPU. Для самых дешёвых видеокарт уровня low-end чаще всего используется 64 и реже 128 бит, для среднего уровня от 128 до 256 бит, ну а видеокарты из верхнего ценового диапазона используют шины от 256 до 384 бит шириной. Ширина шины уже не может расти чисто из-за физических ограничений — размер кристалла GPU недостаточен для разводки более чем 512-битной шины, и это обходится слишком дорого. Поэтому наращивание ПСП сейчас осуществляется при помощи использования новых типов памяти.

9. Частота видеопамяти

Ещё одним параметром, влияющим на пропускную способность памяти, является её тактовая частота. А повышение ПСП часто напрямую влияет на производительность видеокарты в 3D-приложениях. Частота шины памяти на современных видеокартах бывает от 533(1066, с учётом удвоения) МГц до 1375(5500, с учётом учетверения) МГц, то есть, может отличаться более чем в пять раз! И так как ПСП зависит и от частоты памяти, и от ширины ее шины, то память с 256-битной шиной, работающая на частоте 800(3200) МГц, будет иметь бо́льшую пропускную способность по сравнению с памятью, работающей на 1000(4000) МГц со 128-битной шиной.

10. Типы памяти

На современные видеокарты устанавливается сразу несколько различных типов памяти. Старую SDR-память с одинарной скоростью передачи уже нигде не встретишь, но и современные типы памяти DDR и GDDR имеют значительно отличающиеся характеристики. Различные типы DDR и GDDR позволяют передавать в два или четыре раза большее количество данных на той же тактовой частоте за единицу времени, и поэтому цифру рабочей частоты зачастую указывают удвоенной или учетверённой, умножая на 2 или 4. Так, если для DDR-памяти указана частота 1400 МГц, то эта память работает на физической частоте в 700 МГц, но указывают так называемую «эффективную» частоту, то есть ту, на которой должна работать SDR-память, чтобы обеспечить такую же пропускную способность. То же самое с GDDR5, но частоту тут даже учетверяют.

Основное преимущество новых типов памяти заключается в возможности работы на больших тактовых частотах, а соответственно — в увеличении пропускной способности по сравнению с предыдущими технологиями. Это достигается за счет увеличенных задержек, которые, впрочем, не так важны для видеокарт.

Технологии объединения видеокарт

· Технология NVIDIA SLI

SLI (Scalable Link Interface) — это технология объединения двух видеокарт с целью увеличения графической производительности.

Назвать саму идею объединения видеокарт новой нельзя. Как известно, все новое — это хорошо забытое старое. Попытки объединения видеокарт (то есть создания многопроцессорной графической системы) предпринимались и раньше. И если говорить о решениях, которые имели коммерческий успех и завоевали популярность в среде заядлых геймеров, то уместно вспомнить технологию Scan Line Interleave (SLI), позволившую объединять в единое решение две графические карты на базе процессоров 3Dfx Voodoo 2.

Суть технологии Scan Line Interleave (чередование строк кадра) была отражена в ее названии: один графический процессор отвечал за обработку четных строк кадра, а другой — за обработку нечетных. Таким образом, нагрузка на графические процессоры делилась пополам, а общая производительность увеличивалась.

Предпринимались и другие попытки создания многопроцессорных графических решений, однако коммерческого успеха они не имели.

С выпуском графического интерфейса PCI Express совместное использование двух графических карт вновь стало возможным. Компания NVIDIA уже давно поняла потенциал новой шины и внедрила некоторое подобие функции 3Dfx SLI в новейший графический процессор NV40, также известный как GeForce 6800.

Итак, что же представляет собой новая технология NVIDIA SLI? Для реализации возможности объединения двух видеокарт информацию рендеринга следует разделить между двумя картами. Кроме того, нужен метод передачи информации об изображении второй карты на первую карту, к которой подключен монитор. Наконец, две части изображения должны быть объединены на экране монитора.

Поэтому одна из видеокарт, работающих в режиме NVIDIA SLI, является ведущей, а вторая — ведомой, при этом ведущая карта отвечает за сборку финального кадра и вывод его на экран.

Для объединения видеокарт в технологии NVIDIA SLI использует простое U-образное мостовое соединение двух карт, которое обеспечивает синхронизацию и передачу изображения. В результате этого соединения отпадает потребность в использовании внешнего кабеля.

Если вернуться в дни карт Voodoo 2, то технология SLI была довольно сложной, поскольку помимо двух карт Voodoo 2 требовалась "нормальная" 2D-карта для 2О-приложений. Сигнал VGA этой 2О-карты передавался на карты Voodoo 2 с помощью внешнего кабеля, в то время как синхронизация двух карт Voodoo 2 и обмен информацией между ними осуществлялись по ленточному шлейфу. Графическая информация разделялась таким образом, что одна карта выводила только четные строки кадра, а другая — нечетные. Затем результаты складывались или чередовались — отсюда и название Scan Line Interleave.

Технология NVIDIA SLI (Scalable Link Interface) имеет ряд принципиальных отличий от 3Dfx SLI. Главное из них заключается в самом принципе обработки кадров. Технология NVIDIA SLI предлагает два режима работы для увеличения производительности: Split Frame Rendering (SFR) и Alternate Frame Rendering (AFR). Режим AFR — это поочередный рендеринг кадров, то есть одна видеокарта отвечает за рендеринг одного кадра, а вторая — за рендеринг другого.

В режиме SFR одна видеокарта отвечает за обработку верхней половины сцены кадра, а вторая — за обработку нижней половины. Кроме того, разделение кадра на верхнюю и нижнюю половины не ограничено соотношением 50/50, а является гибким. Используя технику динамической балансировки нагрузки, нагрузка между видеокартами делится пополам, позволяя каждой из них работать в полную силу. Вполне очевидно, что технология балансировки нагрузки необходима и эффективна, поскольку в большинстве игр нижняя часть сцены обычно имеет высокую сложность с множеством деталей, а верхняя половина чаще всего отображает только статическое небо.

Для реализации технологии NVIDIA SLI на практике потребуются две видеокарты с интерфейсом PCI Express, поддерживающие данную технологию (например, на базе графического процессора GeForce 6800), мостовой соединитель и материнская плата, имеющая два слота PCI Express xl6.

Обе графические карты должны принадлежать к одному классу производительности, то есть можно объединять только две карты GeForce 6800 Ultra, две GeForce 6800 GT или две GeForce 6800 (стандарт). Смесь различных видеокарт работать не будет, хотя в теории должна бы — ведь здесь используется балансировка нагрузки.

Кроме того, до недавнего времени требовалось (сейчас такого жесткого условия нет), чтобы объединяемые по технологии SLI видеокарты имели одну и ту же версию BIOS.

· Технология ATI CrossFire

Альтернативная технология, позволяющая объединять две видеокарты для увеличения производительности, получила название ATI CrossFire. По сравнению с технологией NVIDIA SLI у ATI CrossFire имеется ряд принципиальных отличий и преимуществ. Напомним, что технология NVIDIA SLI имеет несколько ограничений: обе карты должны быть абсолютно идентичны или, другими словами, обладать одним и тем же BIOS (правда, требование идентичных BIOS было только в первых реализациях технологии NVIDIA SLI). Кроме того, режим SLI работает далеко не со всеми играми, а если и работает, то в ряде случаев не дает желаемого прироста производительности. К тому же эффективность технологии NVIDIA SLI и список поддерживаемых ею игр в значительной мере зависят от используемого видеодрайвера.

Технология ATI CrossFire работает со всеми играми под DirectX и OpenGL. Объединяемые видеокарты не обязательно должны быть одинаковыми и могут быть произведены разными компаниями. Технология ATI CrossFire подразумевает больше режимов рендеринга, чем NVIDIA SLI, и поддерживает режим улучшения качества изображения.

На первый взгляд, CrossFire имеет немало общего с NVIDIA SLI: для работы CrossFire требуется материнская плата с двумя слотами PCI Express xl6 под графику. Хотя CrossFire теоретически не зависит от чипсета, ATI утверждает, что система будет работать только на материнских платах с чипсетом Radeon Xpress 200 CrossFire.

CrossFire-версия несколько отличается от обычных карт ATI. Для сборки системы CrossFire, кроме стандартной графической карты Radeon X800 или Х850 (ведомая/slave), потребуется специальная версия видеокарты Radeon X800 или Х850 CrossFire (ведущая/master). При этом видеокарты не соединяются между собой мостиком — только специальным внешним кабелем.

Специальный чип на ведущей CrossFire-карте смешивает картинки, сгенерированные обычной и CrossFire-картой, после чего выводит изображение на дисплей. Смешивание происходит попиксельно.

Разделение на простую и CrossFire-версию карт, на первый взгляд, можно расценить как недостаток по сравнению со SLI, так как в случае с решением NVIDIA вам не нужно думать, какую карту брать, — обе одинаковые. Но если вдуматься, концепция ATI дает определенные преимущества.

Владельцы Radeon X800 или Х850 могут без проблем докупить к своей системе любую модель CrossFire. Здесь не играют роли ни различия в тактовых частотах, ни в версиях BIOS, ни в конфигурации конвейера, ни в производителях. Единственное ограничение — модель CrossFire должна соответствовать другой графической карте. Другими словами, быть картой Х800 или Х850.

CrossFire-версия карты координирует тактовые частоты и адаптируется к обычной карте на основе пиксельных конвейеров. Скажем, если обычная карта использует 12 активных пиксельных конвейеров, то CrossFire-карта тоже перейдет на 12 конвейеров. Но за гибкость приходится платить. Владельцы младшей Х800 или Х850 заплатят достаточно приличную сумму за CrossFire-версию карты, по сравнению со своей, и не факт, что они получат большой выигрыш, ведь темп гонки будет задавать обычная карта.

Технология ATI CrossFire обеспечивает четыре режима работы:

□ SuperTiling;

□ Scissor;

□ Alternate Frame Rendering (AFR);

□ Super AA.

Режим Super Tiling — это стандартный режим для технологии CrossFire. Он работает для всех игр и приложений Direct3D. Следует отметить, что современные графические процессоры не обрабатывают одновременно все изображение — они разделяют его на небольшие квадраты (quads), которые раскладываются процесс сором по разным конвейерам. В режиме Super Tiling экран разбивается на отдельные квадраты размером 32 х 32 пиксела так, что каждая видеокарта получает изображение с выделенными в шахматном порядке фрагментами для обработки. Таким образом, нагрузка делится строго поровну между кадрами, независимо от конкретной сцены, а вот геометрическую нагрузку приходится дублировать — обе карты рассчитывают одни и те же геометрические данные.

К преимуществам данного режима относится возможность работы со всеми играми и приложениями, а также оптимальное распределение нагрузки (с точки зрения пикселов). В то же время в некоторых приложениях в режиме SuperTiling производительность возрастает незначительно. Обе карты должны просчитывать всю геометрию сцены, даже если затем они будут вычислять половину пикселов. В играх, которые усиленно используют пиксельные программы, можно ожидать более высокого прироста производительности. Кроме того, режим SuperTiling не работает с играми OpenGL.

Режим рендеринга Scissor разделяет экран на две части по горизонтали (рис. 4.13). Одна карта вычисляет верхнюю часть экрана, а вторая — нижнюю. Динамическая балансировка нагрузки позволяет разделить экран на части таким образом, чтобы на карты ложилась равная вычислительная нагрузка. Такой режим является стандартным для приложений OpenGL. Кроме того, данный режим позволяет получить прирост производительности в большинстве игр. В то же время, как и в случае SuperTiling, в режиме Scissor обе видеокарты должны полностью просчитывать геометрию сцены.

Режим Alternate Frame Rendering (AFR) подразумевает поочередный рендеринг кадров каждым графическим процессором (рис. 4.14). Одна карта просчитывает все нечетные кадры, а вторая — все четные. Принцип легко понять, если учесть, что меняющаяся сцена всегда состоит из последовательности отдельных кадров, которые быстро сменяют друг друга, создавая впечатление непрерывного движения.

Преимущество такого решения состоит в том, что обе карты оптимально распределяют вычислительную нагрузку. Однако в ряде случаев использование режима AFR невозможно, например, когда обработка следующего кадра напрямую зависит от результатов обработки предыдущего.

Четвертый режим CrossFire называется Super AA (Anti-Aliasing). Точнее, речь идет даже не об одном, а о четырех режимах Super AA: 8х АА, 10х АА, 12х АА и 14х АА. В данных режимах карта не обеспечивает более высокой частоты кадров (производительности), но существенно улучшает качество картинки. Эти режимы позволят повысить качество изображения в играх, которые не получают выигрыша в производительности от использования двух видеокарт. Наличие данных альтернативных режимов рендеринга является ключевым отличием технологии ATI CrossFire от NVIDIA SLI.

Режимы Super AA можно использовать во всех приложениях, без каких бы то ни было ограничений, поскольку они не предполагают распределения рабочей нагрузки между двумя видеокартами — каждая карта выполняет рендеринг кадра на основе уникального набора точек - семплов, после чего результаты рендеринга объединяются и формируется единое изображение.

В режиме 8х АА обе карты генерируют одно и то же изображение, причем каждая из них работает в режиме сглаживания изображения 4х, но использует разные точки-семплы (шаблоны сглаживания). Затем чип смешивает обе картинки в одну. В результате пользователь получает сглаживание 8х по цене 4х FSAA.

Аналогично в режиме 12х АА каждая карта работает в режиме сглаживания изображения 6х, но использует разные шаблоны. В результате смешивания картинок получается режим сглаживания 12х АА при производительности, соответствующей режиму 6х FSAA.

В режимах 10х АА и 14х АА используется принципиально новая концепция режима SSAA (SuperSampling АА). Фактически данные режимы сглаживания представляют собой комбинацию режимов 8х АА и 12х АА с новой технологией сглаживания 2х SuperSampling АА, при котором каждая карта осуществляет обработку всей сцены с необходимым разрешением и сдвигом на полпиксела по диагонали. В итоге рендеринг сцены фактически выполняется в режиме Юх АА (8х АА + 2х SSAA) или 14х АА (12х АА + 2х SSAA).